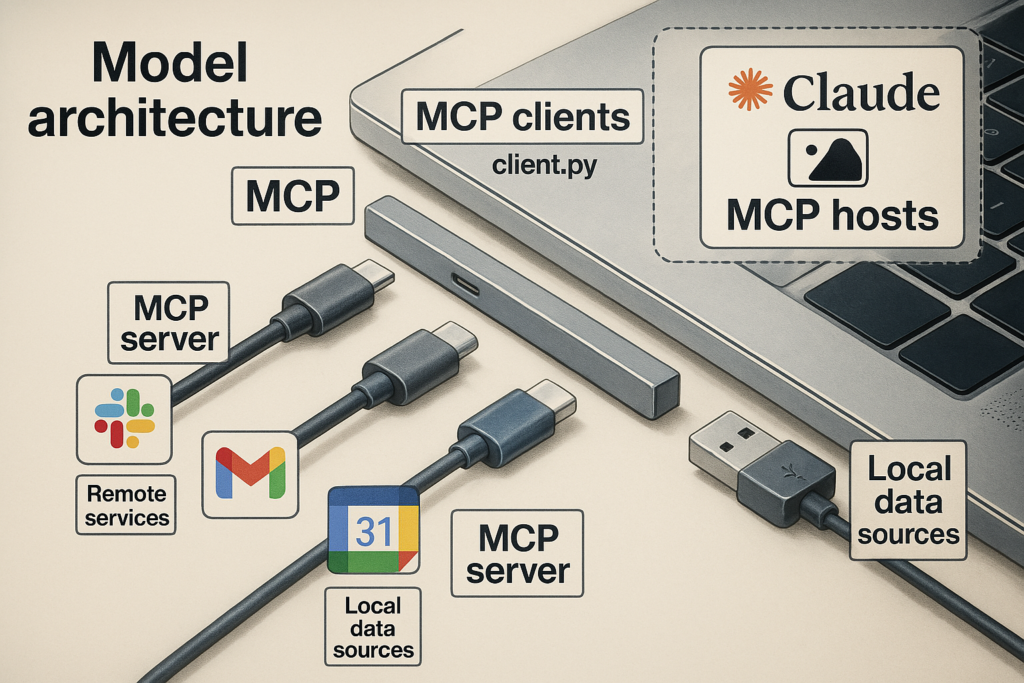

MCP(Model Context Protocol,模型上下文協定)是一項由 Anthropic 推出的開放標準,用於讓大型語言模型(LLM)與外部資料源和工具建立統一的介面連結。簡單來說,MCP 就像 AI 應用的 USB-C 接口:提供一種通用且標準化的方式,讓 AI 模型可以安全地存取各種即時的外部資料和服務。透過 MCP,AI 助手不再局限於訓練期間學到的知識,而是能在需要時即時查詢資訊或執行操作,獲取所需的上下文來產生更相關、精確的回應。

MCP 的定義與簡介

MCP 全稱為 Model Context Protocol(模型上下文協定),是在 2024 年由 Anthropic(Claude AI 的開發公司)提出並開源的一種標準。其誕生的背景在於,目前的先進 AI 模型雖然功能強大,但面臨著**「資訊孤島」的困境:模型與外部世界的資料通常是隔離的。如果我們問一個 AI 助手最新的天氣或要它分析一份當前的文件,在沒有外部連線的情況下,它可能只能回答「不知道」或基於舊資訊胡亂猜測。傳統上,開發者需要為每個數據來源撰寫定制的整合腳本,來餵給模型最新的資訊,但這種做法繁瑣且難以維護。MCP 正是在這樣的需求下應運而生——它旨在標準化** AI 與外部資料來源的溝通方式,打破不同系統間各自為政的碎片化整合。

透過 MCP,開發者可以使用一套通用協定,讓 AI 助手直接連接各種內容庫、企業工具或開發環境等資料源。Anthropic 開源 MCP 後,廣泛邀請社群共同參與,使之成為一個開放社群主導的標準。MCP 的目標是克服 LLM 應用只能依賴訓練資料的限制,讓模型在需要時能即時取得相關的上下文資訊並執行更廣泛的任務。換言之,MCP 為 AI 模型搭建了一座橋樑,將其與外界的**「即時知識」**連結起來,從而提升回答的時效性與相關性。

MCP 架構概念圖:將 MCP 比作 AI 的「USB-C」接口,AI 應用(右上,如 Claude 等 MCP 主機)經由 MCP 客戶端(client.py)透過統一的連接埠,同時對接多個 MCP 伺服器(左下),每個伺服器連結不同的外部資源或工具(如本地資料、Slack、Gmail、行事曆等)。這樣,AI 模型就能即插即用地訪問各類資料來源。

為什麼需要 MCP?

即使是最強大的 AI 模型,若脫離了外部資訊的支援,其能力仍大受限制。傳統上,我們為每個新增的資料來源都得打造專用的整合方案——每個 API 需要各自的調用介面、認證方法和錯誤處理機制,AI 系統難以通用。這導致整體架構非常碎片化:不同應用、不同資料庫、不同工具之間缺乏統一標準,想讓 AI 連上新系統就得從頭開發新的「插件」。隨著一個 AI 需要對接的外部服務愈來愈多,維護這些複雜且零散的整合會變得困難且低效。

MCP 的出現正是為了解決上述痛點。 首先,LLM 模型缺乏即時資訊的問題在 MCP 框架下迎刃而解:如果用戶的提問涉及模型未掌握的新知識,AI 助手可以透過 MCP 去查詢相應的外部資料來源,而不是像過去那樣因不知道而無法作答。其次,相較於過去每新增一個資料源就得寫一套新代碼,MCP 提供了統一標準來取代繁瑣的單次整合。開發者現在可以針對 MCP 標準構建整合,無需為每種工具各寫各的接駁程式,大幅降低開發和維護成本。Anthropic 官方表示,MCP 的目的在於以單一協定取代眾多不相容的接口,讓 AI 系統獲取所需資料變得更簡單可靠。總而言之,MCP 帶來的是可擴充、易整合且即時的AI資料連接解決方案。

Model Context Protocol 的技術原理

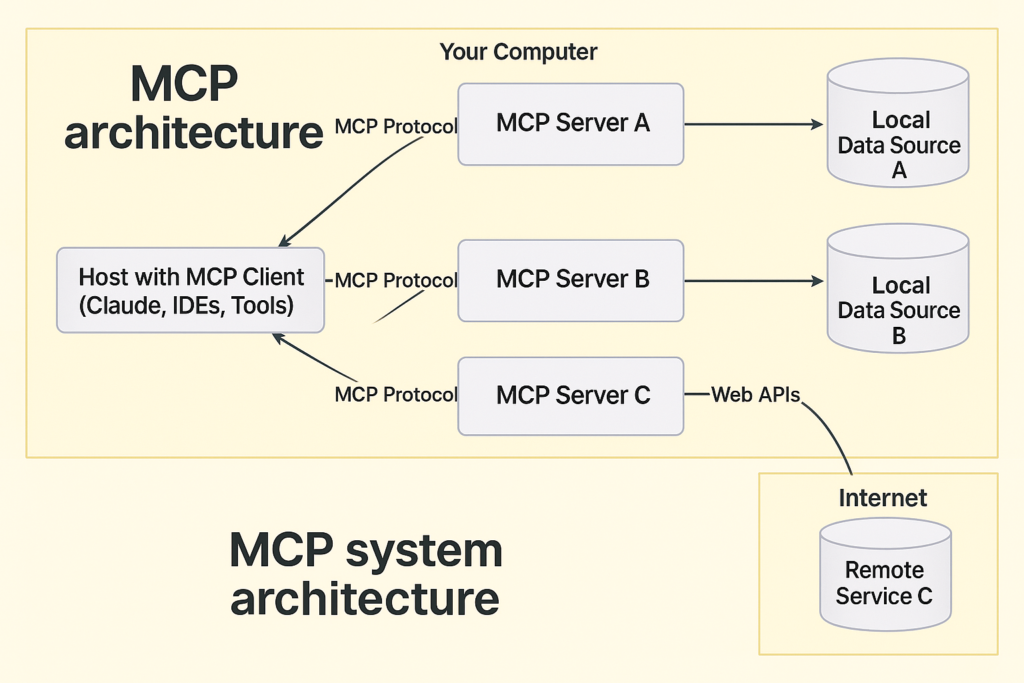

MCP 採用了客戶端-伺服器的架構,將 AI 與資料源的互動劃分為明確的角色與流程。主要涉及三個部分:

- MCP 主機(Host):發起對外資料請求的 AI 應用本身,例如 Claude 桌面應用、編輯器中的 AI 助理或聊天機器人等。主機內部集成了 MCP 客戶端,用於處理和轉發請求。

- MCP 客戶端(Client):嵌入在主機應用中的連接器,負責按照 MCP 協定與外部的 MCP 伺服器建立一對一的連線。它將主機的請求打包後發送給對應的伺服器,並接收伺服器的回應再傳回主機。同時,MCP 客戶端確保通訊的安全性,包括權限驗證和資料格式統一。

- MCP 伺服器(Server):部署在資料來源一側的輕量程式。每個 MCP 伺服器負責連接一種或一組特定的外部資源(可以是本地檔案系統、資料庫,或網路服務的 API),按照 MCP 標準接收客戶端請求並執行操作,最後將取得的資料或結果以標準化格式回傳給客戶端。

MCP 系統架構示意圖:一個運行著 MCP 客戶端的 AI 主機(左,下紫色框)可以透過 MCP 協定同時連接多個 MCP 伺服器。每個伺服器都對應並連接到不同的外部資料來源,例如本地資料庫或檔案(右上方的本地資料源 A、B),或經由網路 API 存取遠端服務(右下方的 Remote Service C)。MCP 客戶端與各伺服器之間保持一對一的持續連線,在整個對話過程中可以多次發送請求、取得回應,彷彿 AI 模型擁有多條數據管道隨時汲取所需資訊。

在這種架構下,當使用者向 AI 提出問題時,AI 主機若「知道」該問題需要外部資訊(例如查詢天氣、存取文件內容等),便由內部的 MCP 客戶端生成一個請求,以 JSON-RPC 等標準訊息格式透過協定發給相應的 MCP 伺服器。伺服器收到請求後,會與背後對接的資料源交互(例如呼叫某個Web API或查詢資料庫),將取得的結果封裝為預先定義的結構化資料(如 JSON)返回。AI 主機隨即把這些外部資料納入模型的上下文,使 LLM 可以基於最新資訊來產生回答或執行進一步操作。整個過程對終端用戶是透明的 —— 他們只會感覺到 AI 助手的回答更加即時且切中要點,殊不知背後模型其實已經通過 MCP 即時查庫或調用工具來輔助自己完成了任務。值得一提的是,MCP 協定還考慮了雙向通信和持續會話的需求。傳統的 REST API 通常是請求-回應一次性結束,而 MCP 的連線是保持狀態的,允許在同一會話中多輪交互。例如,一個 AI 助手可以先向某個 MCP 伺服器請求數據,稍後根據用戶新的指示再對同一伺服器發起後續請求,過程連貫而不需每次重新建立連線。此外,MCP 還支援能力協商(Capability Negotiation):在客戶端和伺服器建立連線時,雙方可以交換各自支援的功能列表,以便了解彼此有哪些能力(例如伺服器提供哪些工具接口,客戶端支援哪些資料格式等)。這確保了不同實作之間的互通性和自適應性:當某伺服器提供的新功能出現時,AI 代理也能通過協商發現並利用它。

總的來說,MCP 的技術原理透過嚴謹的協定設計(基於 JSON-RPC 2.0 等標準)實現了 LLM 與外部世界的無縫溝通。模型可以在需要時動態取得知識、數據或執行操作,而不是被封閉在自己的語言模型宇宙裡。這為打造更聰明、更實用的 AI 應用奠定了基礎。

MCP 與傳統模型 API 的差異

雖然傳統的 API 已經在軟體整合領域使用多年,但 MCP 相較於一般的 Web API 或模型 API,有幾個專為 AI 應用設計的明顯差異與優勢:

- 整合範圍:傳統 API 一次通常只能連接一種服務,開發者需要為每個外部系統各自整合;而 MCP 則像一個集線器,一套協定即可橋接多個資料源,讓 AI 模型同時從不同管道獲取資訊。

- 互動模式:傳統模型 API(如一般 REST 接口)以靜態請求-回應為主,缺乏長連線的概念,每次調用彼此獨立;MCP 支援即時雙向互動,在一個持續會話中可進行多輪資料查詢和工具調用,適合複雜任務的上下文傳遞。

- 資源發現:傳統方式下,模型不知道有哪些外部工具可用,往往需要開發者硬編流程;而 MCP 協定內建自我描述能力,允許伺服器宣告其可提供的資源與操作,模型代理可以動態探索可用工具清單。

- 擴充彈性:使用傳統 API 增加新功能時,往往需要重新設計整合;MCP 則採模組化設計,新增一個 MCP 伺服器就如同插上新設備,即插即用,無需改動現有AI應用邏輯。

- 安全控制:不同服務的 API 安全機制各異(有的用API密鑰,有的OAuth等等),難以一致管理;MCP 則強調統一的存取控制,在協定層面提供驗證與權限管理框架,讓跨多工具的訪問遵循一致的安全策略。

- AI 專屬設計:傳統 API 並非為 LLM 量身打造,很多資料需要人工解析轉換給模型;MCP 則充分考量 AI 使用情境,標準返回結構化上下文供模型直接使用,並可配合提示模板等功能提升模型對接效率。

- 文件依賴:傳統 API 需要查閱各自文件來理解用法;MCP 的工具描述和接口定義在協定中自我描述,AI 代理理論上可自行讀取了解如何使用某個 MCP 工具,而不完全依賴人工查看說明。

- 通訊方式:大多數傳統網路 API 基於無狀態的 HTTP 請求,缺少會話連續性;MCP 採用有狀態連線,並支援多種傳輸層(從本地標準輸入輸出管道到網路協議皆可),提供更豐富的通訊模式。

綜上所述,傳統模型 API 每對接一個新系統就像搭一條單獨的橋,而 MCP 則是修築一條通用高速公路,讓各種資料源都能匯入同一通道。傳統方式下,整合多個外部資源會導致開發過程複雜且冗長,每個部分可能有各自的格式與規則;相比之下,MCP 通過提供標準化的接口,使 AI 可以透過單一協定訪問多個工具與服務,大幅降低了整合難度。對 AI 開發者而言,這代表更快的開發迭代和更低的維護成本;對用戶而言,則意味著更智慧且反應迅速的 AI 助手。

Anthropic 如何運用 MCP?實際案例分享

作為 MCP 的倡導者,Anthropic 自然率先在自家產品中實現了 MCP 的應用。其中最具代表性的就是 Claude AI 的桌面應用(Claude Desktop)。Claude Desktop 已內建對 MCP 的支援,允許用戶通過簡單的設定就將 Claude 連接到本機的各種資料和工具。例如,使用者可以在設定中註明本地硬碟文件目錄的 MCP 伺服器,Claude 之後便能透過 MCP 存取該目錄下的文件內容;又或者配置一個瀏覽器控制的 MCP 伺服器,Claude 就能幫你打開網頁並讀取其中資訊。這種桌面級的 MCP 支援,使得非技術用戶也能輕鬆將 AI 助手擴展到自己日常使用的工具和檔案系統上。

除了 Claude 桌面版,Anthropic 還開源並提供了一系列預構建的 MCP 伺服器範例,涵蓋各種常見的資料來源。官方已經針對 Google Drive、Slack、GitHub、Git 儲庫、PostgreSQL 資料庫、Puppeteer 瀏覽器自動化等製作了對應的 MCP 伺服器實作。這些伺服器可以立即佈署,讓 AI 模型能讀取企業雲端硬碟文件、團隊聊天記錄、原始碼庫內容,甚至直接在網頁上執行點擊操作等。透過這些現成模組,開發者和用戶幾乎開箱即用地將 Claude 接入複雜的真實環境。早期採用 MCP 的公司(如 Square 旗下的 Block 和 Apollo)已將 MCP 整合進他們的內部系統,以提升 AI 助手處理業務資料的能力。

MCP 的生態系統正在迅速壯大,不僅 Anthropic,自其他領域的廠商也開始加入。多家開發者工具公司(包括 Zed、Replit、Codeium、Sourcegraph 等)與 Anthropic 合作,利用 MCP 協定來增強其平台功能。以程式碼開發為例,透過 MCP,這些平台上的 AI 代碼助手可以直接檢索更多相關的程式碼片段、文件或專案知識,以更深入瞭解目前的開發上下文,從而產生更準確且有功能性的程式碼建議。又如 Microsoft 也在其 Copilot 開發者工具中加入了對 MCP 的支援,讓開發者能輕鬆將 Copilot 連接到現有的知識庫和 API。事實上,微軟更進一步推出了基於 MCP 的 Playwright-MCP 伺服器,讓像 Claude 這樣的 AI 助手可以透過瀏覽器自動化工具與網頁互動。

另一個有趣的應用案例是日曆與工作流整合:利用 MCP,可以讓 AI 助手讀取用戶的行事曆資料,主動為會議安排時間或提醒待辦事項。再者,在圖形與多媒體領域,有開發者將 MCP 與 3D 建模軟體結合,使 AI 能直接操作如 Blender 這樣的程式來生成或修改 3D 模型。這些案例顯示 MCP 的應用範圍極為廣泛,從日常辦公、自動化助理,到專業領域的垂直整合,都可以看到 MCP 發揮作用的身影。

值得注意的是,OpenAI 也宣佈將支援 MCP。2025 年 3 月底,OpenAI 執行長 Sam Altman 在社群上表示,他們將在旗下產品(包括 ChatGPT 的桌面應用)中加入對 Anthropic 所制定的 MCP 標準的支援。這意味著未來使用 OpenAI 模型的應用也能利用 MCP 來接入各種資料源,形成跨平台的通用生態。Anthropic 對此表示歡迎,強調 MCP 作為開放標準在短短數月內已發展出數以千計的整合,成為繁榮的開放社群。由於 MCP 不局限於任何特定模型,無論 Claude、ChatGPT 或其他 AI,只要遵循這套協定都能共用工具與資料接入的「插件」,這無疑為 AI 行業的協作共融帶來了新可能。

MCP 的優點與未來展望

優點概述: MCP 為 AI 應用帶來了多項創新優勢。首先在效率上,標準化協定大幅降低了多系統整合的門檻,開發者不需重複造輪子,即可讓 AI 即時訪問新的資料源。其次在效果上,模型因能取用即時且專業的上下文資訊,回覆的相關性和精確度明顯提升。透過 MCP,AI 助手變得更上下文感知(Context-Aware):了解用戶當前環境中的資訊,如文件內容、日程安排等,從而提供貼合需求的響應。不僅如此,MCP 的安全架構也讓企業更放心地將內部資料接入 AI 系統——資料存取權限完全由企業掌控在自己的 MCP 伺服器上,協定本身也引入 OAuth 2.1 等認證機制保障傳輸安全。最後,MCP 的開放性意味著整個生態的繁榮:越來越多現成的工具整合被社群貢獻出來,AI 開發者可以自由選擇套用,甚至不同公司的 AI 助手可以共享同一套整合插件,減少重工浪費。

未來展望: 作為一個仍在迅速演進的標準,MCP 展現出了巨大的潛力。預計未來幾年,我們將看到:

- 行業專屬的 MCP 伺服器:針對醫療、金融、教育等垂直領域,會出現定制的 MCP 整合方案,提供專業數據源的即時連接,使 AI 在特定場景下更加專精。

- MCP 平台服務化:可能出現專門提供 MCP 連接執行的雲服務(MCP-as-a-Service),企業只需配置即可讓 AI 安全訪問其數據,而不用自架基礎設施。

- 標準聯盟與治理:隨著 Anthropic、OpenAI 等多方參與,業界或將組建 MCP 標準的聯盟,共同治理和推進協定演化,確保其中立性與持續升級。

- 大型平台廣泛支援:主流的 AI 平台和雲服務供應商(如微軟 Azure、AWS 等)預計也會陸續將 MCP 納入他們的產品中,讓使用者一鍵啟用 MCP 整合能力

- 更強大的開發工具:圍繞 MCP 將誕生更成熟的SDK、調試工具和可視化界面,甚至圖形化的流程編排,讓整合過程更加容易上手且直觀。

總而言之,MCP 的出現代表了 AI 系統與外部世界互動方式的重大進步。透過一套標準化的流程,AI 模型得以方便地存取並運用多元來源的資訊,大幅提升了 AI 應用的效能、準確度與情境感知能力。作為一個開放標準,MCP 有望成為構建未來 AI 生態系統的基石之一——它不僅簡化了開發流程,更將推動各產業的 AI 解決方案邁向更高的互通性與創新性。無論您是希望將 AI 深度整合到業務的企業,或是開發 AI 工具的技術人員,掌握 MCP 並善加利用,都將成為打造高效智慧AI系統的關鍵。

常見問題 FAQ

A1: 不是。雖然 MCP 由 Anthropic 開發提出,但它被設計為開放標準,與模型廠商無關。任何支援該協定的 AI 模型或系統都能使用 MCP。事實上,OpenAI 等公司也已經宣佈將在自家產品中支援 MCP換言之,無論是 Claude、ChatGPT 或其他 LLM,只要實作了 MCP,都可以接入同樣的資料源生態。

A2: 上手 MCP 並沒有想像中困難。Anthropic 以及開源社群提供了多種程式語言的 SDK 工具包(如 Python、TypeScript、Java、Kotlin、C# 等)來協助開發。對一般開發者而言,只需要基礎的編程知識就能利用這些 SDK 快速創建 MCP 客戶端或伺服器。另外,像 Claude Desktop 這樣的現成應用已支援簡單配置後直接使用 MCP,非程式人員也能透過調整設定檔來連接自己的資料源。總之,官方完整的文件與範例極大降低了學習成本。

A3: MCP 的設計充分考量了安全性。首先,資料不會不受控地暴露給 AI —— 所有外部資料的存取都經由您自建或信任的 MCP 伺服器進行,您可對其實施嚴格的權限管理。協定本身也引入了標準的認證與授權機制(如 OAuth2.1)來確保只有授權的請求才能訪問敏感資訊。此外,MCP 通訊採用結構化資料格式,降低了因自由文本輸入而造成注入攻擊的風險。綜合而言,MCP 提供了一個受控的框架,讓 AI 在與外部系統交互時保護您的資料隱私和安全。

A4: 可以。MCP 鼓勵開放生態,您完全能為您特殊的資料源或應用開發自定義的 MCP 伺服器。藉助官方 SDK,建立一個新的伺服器相對簡單:您只需實作協定中定義的介面,處理從客戶端來的請求並返回資料即可。例如,您可以為您公司的內部數據庫開發一個 MCP 伺服器,讓 AI 模型透過 MCP 查詢商業數據。開源社群中已經有許多第三方實作可供參考,您也可以將自己的實作貢獻出來豐富整體生態。

A5: 建議從官方資源入手。您可以參考 MCP 官方 GitHub 頁面來閱讀協定規範、瀏覽範例程式碼,或在其中尋找現有的伺服器/客戶端專案。Anthropic 提供的官方文件也詳細說明了 MCP 的架構、使用指南和最佳實踐。如果只是想體驗成品,可以下載 Claude Desktop 或其他內建 MCP 客戶端的工具,按照文件說明設定幾個 MCP 伺服器進行試用。隨著生態發展,線上也有許多技術社群和討論論壇圍繞 MCP 展開分享,在那裡您可以得到最新的資訊和他人實戰經驗的建議。